Blog

OPEN WebUI 이란 무엇인가?

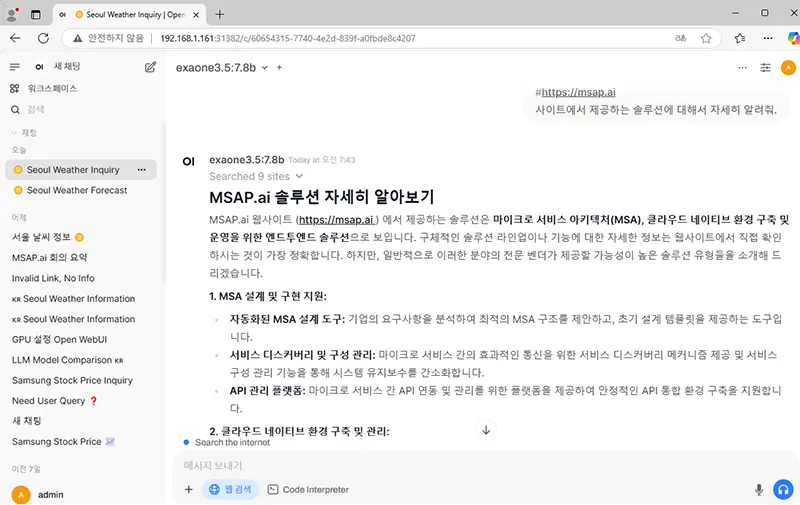

이 글에서는 Open WebUI 의 주요 기능과 활용 방안을 중심으로, 오픈소스 LLM 모델 관리와 최적화 방법을 소개합니다.

2025년 03월 24일

Open WebUI

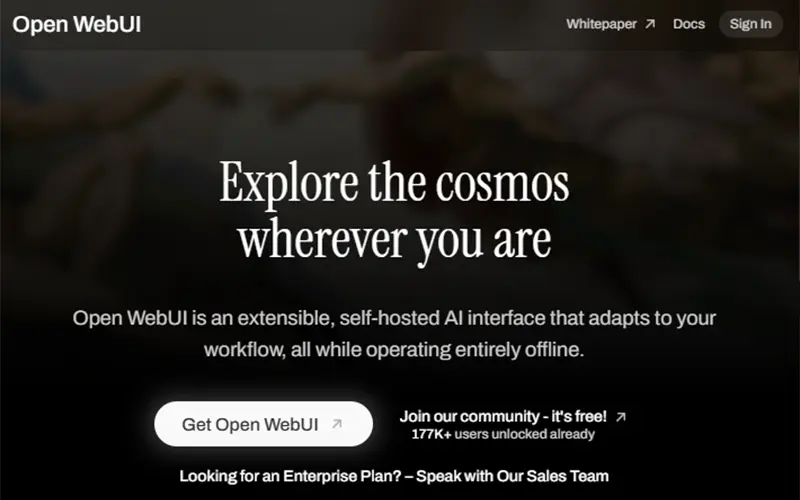

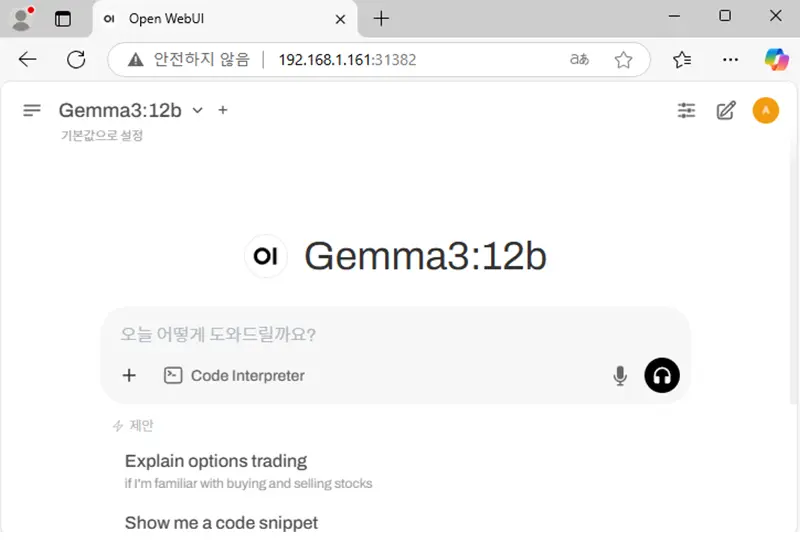

Open WebUI는 대규모 언어 모델(LLM)과의 상호작용을 위한 확장 가능하고 사용자 친화적인 오픈 소스 플랫폼으로, 완전히 오프라인 환경에서도 작동하도록 설계되었습니다.

OPEN WebUI 이란 무엇인가?

Open WebUI는 로컬 환경에서 실행되는 AI 도구로 사용자가 다양한 LLM을 조작할 수 있는 통합 인터페이스를 제공합니다. 이 도구는 AI에 익숙하지 않은 사용자도 직관적으로 사용할 수 있도록 설계되었으며 설정 및 조작이 간단합니다. 주요 기능으로 여러 LLM에 액세스하고 선택한 모델에 따라 작업을 수행할 수 있습니다. 또한 이러한 모델은 문서 생성 및 코드 완성과 같은 특정 요구에 맞는 출력을 제공하므로 다양한 상황에서 활용할 수 있습니다.

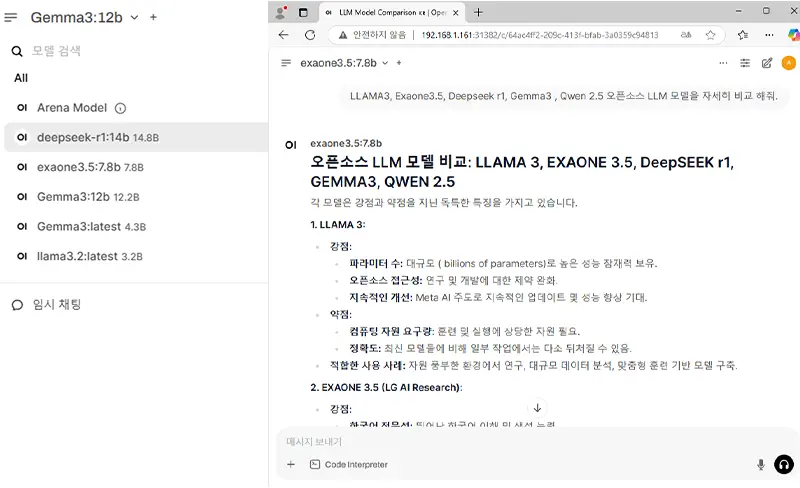

Chatgpt 와 OPEN WebUI 비교 그리고 오픈소스 LLM 모델(LLAMA, GEMMA, DeepSeek, EXAONE 등)들

Open WebUI는 오픈소스 기반의 AI 모델 관리 및 인터페이스 플랫폼으로서, ChatGPT와 같은 상용 LLM 서비스와 비교하여 여러 가지 독특한 장점을 제공합니다.

특히, LLAMA, GEMMA, DeepSeek, EXAONE 등과 같은 오픈소스 LLM 모델들과 결합하여 활용할 경우, 다음과 같은 이점이 두드러집니다:

| 비교 항목 | Open WebUI (오픈소스 기반) | ChatGPT (상용 LLM 서비스) |

|---|---|---|

| 맞춤화와 유연성 |

|

|

| 데이터 보안 및 프라이버시 보호 |

|

|

| 다양한 모델 활용 및 통제력 |

|

|

| 비용 효율성과 확장성 |

|

|

| 투명성과 커뮤니티 지원 |

|

|

이러한 장점들을 통해 Open WebUI와 오픈소스 LLM 모델들의 결합은 사용자에게 높은 수준의 맞춤화, 보안, 비용 효율성, 투명성, 그리고 최신 기술 활용을 가능하게 합니다. 이는 상용 LLM 서비스와 비교하여 유연하고 경제적인 AI 솔루션을 구축하는 데 큰 도움이 됩니다

OPEN WebUI ((Formerly Ollama WebUI) 시작

Open WebUI의 이름은 프로젝트의 발전 과정에서 변경되었습니다. 초기에는 Ollama를 위한 웹 기반 사용자 인터페이스로 설계되어 ‘OllamaWebUI’라는 이름을 사용했습니다. 그러나 오픈소스로 발전하면서 Ollama뿐만 아니라 다양한 오픈소스 LLM(Local Large Models)을 지원하게 되었고, 이에 따라 이름을 ‘Open WebUI’로 변경하였습니다.

이 프로젝트는 GitHub에서 ‘open-webui’라는 이름으로 관리되고 있으며, 다양한 LLM 러너와의 호환성을 지원합니다. Open WebUI의 개발은 커뮤니티 주도로 이루어졌으며, 주요 기여자 중 한 명인 Timothy Jaeryang Baek에 의해 주도 되었습니다. 프로젝트의 초기 버전은 2023년 10월경에 공개되었으며, 이후 지속적인 업데이트와 개선이 이루어져 왔습니다.

이 플랫폼은 Ollama와 같은 로컬 LLM 프레임워크와의 통합을 통해 사용자가 로컬 환경에서 대형 언어 모델을 쉽게 실행하고 상호작용할 수 있도록 설계되었습니다. 이를 통해 사용자는 네트워크 연결 없이도 AI 모델을 활용할 수 있으며, 데이터 보안과 개인 정보 보호 측면에서 이점을 제공합니다.

Open WebUI는 Docker를 통한 간편한 설치와 다양한 운영 체제(macOS, Windows, Linux)를 지원하여 사용자 편의성을 높였습니다. 또한, Markdown 및 LaTeX 지원, 음성 및 비디오 통화 기능 등 다양한 기능을 제공하여 사용자 경험을 향상시키고 있습니다.

이러한 특징으로 인해 Open WebUI는 로컬 환경에서 AI 모델을 활용하려는 사용자들에게 유용한 도구로 자리매김하고 있습니다.

OPEN WebUI의 주요 기능

- 간편한 설치: Docker 또는 Kubernetes(kubectl, kustomize 또는 helm)를 사용하여 손쉽게 설치할 수 있으며, :ollama 및 :cuda 태그가 지정된 이미지를 지원합니다.

- Ollama/OpenAI API 통합: OpenAI 호환 API를 손쉽게 통합하여 Ollama 모델과 함께 다양한 대화를 나눌 수 있습니다. OpenAI API URL을 사용자 정의하여 LMStudio, GroqCloud, Mistral, OpenRouter 등과 연결할 수 있습니다.

- 세분화된 권한 및 사용자 그룹: 관리자가 세부적인 사용자 역할과 권한을 생성할 수 있도록 하여 안전한 사용자 환경을 보장합니다. 이러한 세분화는 보안을 강화할 뿐만 아니라 사용자 경험을 맞춤화하여 사용자에게 소유감과 책임감을 부여합니다.

- 반응형 디자인: 데스크탑 PC, 노트북, 모바일 기기 등 다양한 장치에서 원활한 경험을 제공합니다.

- 모바일용 프로그레시브 웹 앱(PWA): 모바일 기기에서 네이티브 앱과 유사한 경험을 제공하며, 로컬호스트에서 오프라인 액세스와 원활한 사용자 인터페이스를 제공합니다.

- Markdown 및 LaTeX 완전 지원: 포괄적인 Markdown 및 LaTeX 기능을 통해 LLM 경험을 향상시켜 풍부한 상호작용을 제공합니다.

- 핸즈프리 음성/비디오 통화: 통합된 핸즈프리 음성 및 비디오 통화 기능을 통해 보다 역동적이고 상호작용적인 채팅 환경을 제공합니다.

- 모델 빌더: 웹 UI를 통해 Ollama 모델을 쉽게 생성할 수 있습니다. 사용자 정의 캐릭터/에이전트를 생성하고, 채팅 요소를 커스터마이징하며, Open WebUI 커뮤니티 통합을 통해 모델을 손쉽게 가져올 수 있습니다.

- 네이티브 Python 함수 호출 도구: 도구 작업 공간에서 내장된 코드 편집기 지원을 통해 LLM을 향상시킵니다. 순수 Python 함수를 추가하여 LLM과의 원활한 통합을 가능하게 합니다.

- 로컬 RAG 통합: 획기적인 Retrieval Augmented Generation(RAG) 지원으로 채팅 상호작용의 미래를 경험하세요. 이 기능은 문서 상호작용을 채팅 경험에 원활하게 통합합니다. 문서를 채팅에 직접 로드하거나 문서 라이브러리에 파일을 추가하여 쿼리 전에 # 명령을 사용하여 손쉽게 액세스할 수 있습니다.

- RAG를 위한 웹 검색: SearXNG, Google PSE, Brave Search, serpstack, serper, Serply, DuckDuckGo, TavilySearch, SearchApi, Bing과 같은 제공 업체를 사용하여 웹 검색을 수행하고 결과를 직접 채팅 경험에 주입합니다.

- 웹 브라우징 기능:명령 다음에 URL을 입력하여 웹사이트를 채팅 경험에 원활하게 통합합니다. 이 기능을 통해 웹 콘텐츠를 직접 대화에 포함시켜 상호작용의 풍부함과 깊이를 향상시킵니다.

- 이미지 생성 통합: AUTOMATIC1111 API 또는 ComfyUI(로컬), OpenAI의 DALL-E(외부)와 같은 옵션을 사용하여 이미지 생성 기능을 원활하게 통합하여 동적 비주얼 콘텐츠로 채팅 경험을 풍부하게 합니다.

- 다중 모델 대화: 여러 모델과 동시에 손쉽게 상호작용하여 최적의 응답을 위해 각 모델의 고유한 강점을 활용합니다. 다양한 모델을 병행하여 활용함으로써 경험을 향상시킵니다.

- 역할 기반 접근 제어(RBAC): 제한된 권한으로 안전한 액세스를 보장하며, 승인된 사용자만 Ollama에 액세스할 수 있습니다. 모델 생성/가져오기 권한은 관리자에게만 부여됩니다.

- 다국어 지원: 국제화(i18n) 지원을 통해 선호하는 언어로 Open WebUI를 경험할 수 있습니다. 지원 언어를 확장하기 위해 기여자를 적극적으로 찾고 있습니다.

- 파이프라인, Open WebUI 플러그인 지원: 파이프라인 플러그인 프레임워크를 사용하여 사용자 정의 로직과 Python 라이브러리를 Open WebUI에 원활하게 통합합니다. 파이프라인 인스턴스를 시작하고 OpenAI URL을 파이프라인 URL로 설정하여 무한한 가능성을 탐험하세요. 예를 들어 함수 호출, 사용자 액세스 제한, Langfuse와 같은 도구를 사용한 사용량 모니터링, LibreTranslate를 통한 실시간 번역으로 다국어 지원, 유해 메시지 필터링 등이 있습니다.

- 지속적인 업데이트: 정기적인 업데이트, 수정 및 새로운 기능을 통해 Open WebUI를 개선하는 데 전념하고 있습니다.

OPEN WebUI의 채팅 제어 설정

다음은 Open WebUI의 고급 매개변수와 옵션, 기본값, 각 매개변수의 기능을 포함하여 정리한 표입니다.

| 매개변수 | 옵션 | 기본값 | 기능설명 |

|---|---|---|---|

| 스트림 채팅 응답 | 활성화/비활성화 | 활성화 | 모델의 응답을 실시간으로 스트리밍하여 즉각적인 응답 표시 여부 설정 |

| Function Calling | 활성화/비활성화 | 비활성화 | 외부 함수 호출 기능을 활성화하여, 특정 작업을 실행하도록 설정 |

| 시드(Seed) | 정수 값 (Integer) | 42 | 난수 생성기의 초기값으로, 동일 시드 값 사용 시 일관된 결과 보장 |

| 중지 시퀀스(Stop Sequence) | 문자열 또는 문자열 배열 | 없음 | 특정 단어나 문구가 등장하면 응답 생성을 즉시 중지하도록 설정 |

| 온도(Temperature) | 0.0 ~ 1.0 | 0.7 | 값이 높을수록 창의적이며 다양한 응답을 생성하며, 낮을수록 예측 가능하고 일관된 응답 생성 |

| Reasoning Effort | 0.0 ~ 1.0 | 0.5 | 모델이 응답 시 추론 과정에 들이는 노력의 정도를 설정 (높을수록 복잡한 문제에 깊은 사고 진행) |

| Logit Bias | 딕셔너리 형태 (key-value) | 없음 | 특정 단어나 표현의 사용 확률을 높이거나 낮추도록 편향을 적용하는 기능 |

| Mirostat | 활성화/비활성화 | 비활성화 | 응답 품질을 일정하게 유지하기 위한 확률 조정 알고리즘 사용 여부 |

| Mirostat Eta | 0.001 ~ 1.0 | 0.1 | Mirostat의 학습률을 조정하여 응답 품질을 더욱 세밀하게 제어 |

| Mirostat Tau | 0.0 ~ 1.0 | 0.5 | Mirostat 알고리즘의 목표 응답 다양성 수준을 설정 |

| Top K | 0 ~ 100 | 50 | 확률이 높은 상위 K개 토큰 내에서만 응답을 생성하여 응답 범위를 제한 |

| Top P | 0.0 ~ 1.0 | 0.9 | 누적 확률이 지정한 값(P)에 도달할 때까지만 고려하여 응답의 다양성을 조절 |

| 최소 P(Minimum P) | 0.0 ~ 1.0 | 0.0 | 응답 선택 시 최소 확률 제한을 두어 지나치게 희귀한 표현 선택 방지 |

| 빈도 페널티(Frequency Penalty) | -2.0 ~ 2.0 | 0.0 | 특정 단어의 반복 사용 빈도를 낮추도록 페널티 부여 |

| Presence Penalty | -2.0 ~ 2.0 | 0.0 | 이전에 등장했던 단어나 주제 재사용을 방지하여 응답의 신선도를 유지 |

| Repeat Penalty (Ollama) | 1.0 ~ 2.0 | 1.1 | Ollama 모델의 단어 반복 사용을 억제하여 응답 품질을 향상 |

| 마지막 N 반복(Last N Repeat) | 0 ~ 100 | 64 | 최근 N개의 토큰 내 반복되는 단어를 사용하지 않도록 설정하여 반복성 최소화 |

| Tfs Z | 0.0 ~ 1.0 | 0.0 | Tail Free Sampling 알고리즘을 사용하여 응답의 다양성과 자연스러움을 제어 |

| 내용 길이(Context Length) | 0 ~ 4096 | 2048 | 모델이 참조할 수 있는 대화 맥락의 최대 길이 (컨텍스트 윈도우) |

| 배치 크기(num_batch) | 1 ~ 128 | 1 | 모델이 데이터를 처리할 때 한 번에 처리하는 배치 크기 (성능과 자원 사용량에 영향) |

| 컨텍스트 유지 토큰 수(num_keep) | 0 ~ 4096 | 0 | 컨텍스트를 새로 갱신할 때 이전 컨텍스트에서 유지할 토큰 수를 설정 (대화 맥락 유지) |

| 최대 토큰(num_predict) | 1 ~ 4096 | 256 | 단일 응답에서 모델이 생성할 수 있는 최대 토큰(단어 또는 문자) 수를 설정 |

| use_mmap (Ollama) | 활성화/비활성화 | 활성화 | 메모리 맵(mmap) 기능 사용 여부를 설정하여 메모리 사용 효율성 제어 |

| use_mlock (Ollama) | 활성화/비활성화 | 비활성화 | 메모리 락(mlock) 기능 사용 여부를 설정하여 성능 및 메모리 관리 방식 조절 |

| num_thread (Ollama) | 1 ~ 시스템 최대 스레드 수 | 시스템 최대 스레드 수 | Ollama 모델 실행 시 사용할 CPU 스레드 개수를 설정하여 성능 최적화 |

| num_gpu (Ollama) | 0 ~ 시스템 최대 GPU 수 | 1 | 모델 실행 시 GPU를 활용할 수 있는 개수를 설정하여 성능 향상 |

OPEN WebUI 의 핵심 기능들

1) Open WebUI 워크스페이스의 모델(Models) 기능 및 특징

Open WebUI에서 모델(Models)은 사용자가 원하는 목적에 맞춰 AI 모델을 관리하고 세부적으로 설정할 수 있게 지원하는 핵심적인 기능입니다. 특히, 다양한 모델을 자유롭게 추가하고 관리함으로써 작업 환경에 최적화된 맞춤형 AI 서비스를 구축할 수 있도록 합니다.

1. 모델 관리 및 추가

- 워크스페이스 내에서 여러 개의 AI 모델을 추가하거나 관리할 수 있습니다.

- 예를 들어, Ollama, GPT-4, GPT-3.5와 같은 다양한 LLM을 추가하여 서로 다른 목적에 활용할 수 있습니다.

2. 모델 별 프롬프트 설정

- 각 모델마다 별도의 시스템 프롬프트(System Prompt)를 설정하여, 모델의 역할이나 응답 스타일을 지정할 수 있습니다.

- 예시: 특정 모델에 대해 “마케팅 전문가처럼 답변하기” 또는 “초보자에게 쉽게 설명하기” 등의 지침을 부여할 수 있습니다.

3. 모델 최적화 및 세부 매개변수 설정

- 온도(Temperature), Top-p, 반복 페널티(Repeat Penalty), 최대 토큰(Max Tokens) 등 다양한 고급 매개변수를 모델별로 개별적으로 조정하여, 응답의 품질과 창의성, 정확성을 원하는 방향으로 세부 조율할 수 있습니다.

4. 다중 모델 동시 활용

- 워크스페이스 내에서 여러 AI 모델을 동시에 활성화하여, 특정 작업에 가장 적합한 모델을 즉각 선택하거나 병렬로 비교하며 사용할 수 있습니다. 이를 통해 각 모델의 강점과 약점을 실시간으로 확인하면서 최적의 결과를 얻을 수 있습니다.

5. 모델 접근 권한 설정

- 사용자의 역할 및 그룹에 따라 특정 모델에 대한 접근 권한을 설정할 수 있어, 관리자가 조직의 내부 보안을 강화하고 민감한 정보를 보호할 수 있게 합니다.

6. 모델 빌더(Model Builder)

- 사용자가 직접 커스텀 Ollama 모델을 생성할 수 있도록 도와주는 기능입니다.

- 모델 빌더를 통해 사용자는 맞춤형 캐릭터(에이전트)를 생성하거나, 특정 데이터와 프롬프트로 미세 조정한 모델을 손쉽게 만들고 배포할 수 있습니다.

7. 모델 리소스 관리

- 각 모델의 CPU 및 GPU 사용량, 메모리 할당 등 리소스를 세부적으로 관리하고, 하드웨어 리소스에 따라 모델 성능을 최적화하여 효율적으로 관리할 수 있습니다.

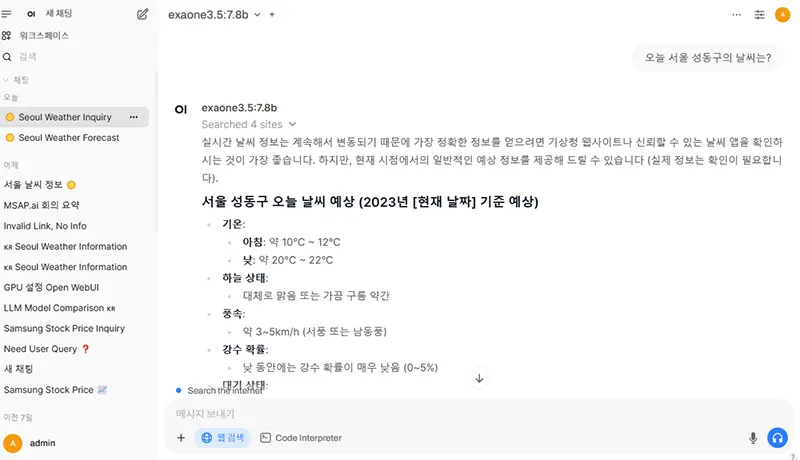

2) OPEN WebUI 웹 검색 기능

1. 다양한 웹 검색 제공자 지원

Open WebUI는 다양한 웹 검색 엔진을 사용할 수 있도록 지원하여 사용자가 원하는 검색 제공자를 자유롭게 설정하여 사용할 수 있습니다/

- Google Custom Search (PSE)

- Bing

- DuckDuckGo

- Brave Search

- SearXNG

- TavilySearch

- serpstack, serper, Serply, SearchApi 등 다수 제공자 지원

2. 모델 별 프롬프트 설정

AI 모델은 일반적으로 훈련된 시점까지의 정보만 알고 있지만, 웹 검색 기능을 사용하면 실시간 최신 정보를 참조하여 답변할 수 있어 더욱 정확하고 신뢰할 수 있는 정보를 얻을 수 있습니다.

- 뉴스, 최신 사건, 현재 날씨, 시황 정보 등 최신성 정보 제공 가능

- “2025년 ChatGPT 최신 기능은?”

- “오늘 서울 성동구의 날씨는?”

- Open WebUI는 설정된 검색 엔진을 통해 즉시 검색 결과를 찾아 답변을 제공합니다.

3. RAG(지식기반 검색)과의 결합 사용

웹 검색 결과를 Retrieval-Augmented Generation(RAG) 방식으로 AI 응답에 자연스럽게 통합하여, 사용자가 더욱 유용하고 자연스러운 정보를 받을 수 있도록 지원합니다.

- 예를 들어, 특정 주제에 대해 AI가 자체적인 지식과 웹상의 최신 정보를 결합하여 응답합니다.